خبر های ویژه

17 اردیبهشت 1404

پلیس پیشبینیکننده با هوش مصنوعی در حال گسترش است − پاسخگویی آن به عموم میتواند اثرات زیانبارش را مهار کند

ماریا لونگو پژوهشگر پسادکتری حقوق و مدیریت عمومی، دانشگاه ویرجینیا

فیلم هیجانانگیز علمی-تخیلی «گزارش اقلیت» محصول سال ۲۰۰۲، آیندهای دیستوپیایی را به تصویر کشید که در آن یک واحد پلیس تخصصی وظیفه داشت افراد را به خاطر جرایمی که هنوز مرتکب نشدهاند دستگیر کند. این فیلم به کارگردانی استیون اسپیلبرگ و بر اساس داستانی کوتاه از فیلیپ کی. دیک، حول محور «پیشجرم» میچرخید − سیستمی که با کمک سه روانبین یا «پیشبین» آینده قتلها را پیشبینی میکرد و به پلیس اجازه میداد مداخله کند و از وقوع جرم جلوگیری نماید. این فیلم پرسشهای اخلاقی سنگینی را مطرح میکند: چگونه میتوان کسی را به خاطر جرمی که هنوز مرتکب نشده مقصر دانست؟ و وقتی سیستم اشتباه میکند چه اتفاقی میافتد؟ اگرچه چیزی به نام «پیشبین» همهچیزدان وجود ندارد، اما اجزای کلیدی از آیندهای که «گزارش اقلیت» تصور کرده بود، حتی سریعتر از آنچه سازندگانش پیشبینی کرده بودند، به واقعیت تبدیل شدهاند. بیش از یک دهه است که ادارات پلیس در سراسر جهان از سیستمهای دادهمحور برای پیشبینی زمان و مکان وقوع جرم و افرادی که ممکن است مرتکب آن شوند استفاده میکنند. پلیس پیشبینیکننده دیگر یک مفهوم انتزاعی یا آیندهنگرانه نیست؛ بلکه واقعیتی است. تحلیلگران بازار پیشبینی میکنند که این فناوری با رشد چشمگیری مواجه خواهد شد. با توجه به چالشهای استفاده مؤثر و عادلانه از یادگیری ماشین پیشبینیکننده، پلیس پیشبینیکننده نگرانیهای اخلاقی قابلتوجهی را برمیانگیزد. در غیاب راهحلهای فناورانه در آینده نزدیک، رویکردی برای رسیدگی به این نگرانیها وجود دارد: استفاده دولت از این فناوری را بهعنوان موضوعی برای پاسخگویی دموکراتیک در نظر گرفتن.

تبریز امروز:

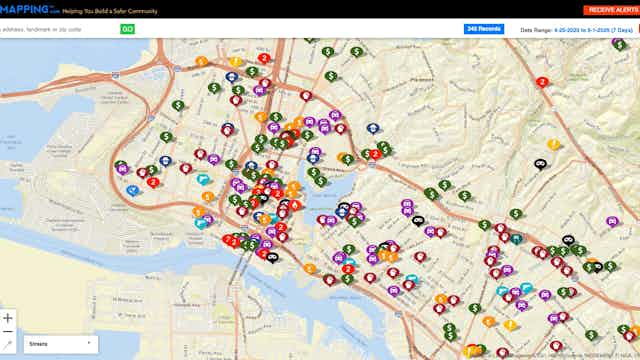

پلیس پیشبینیکننده به هوش مصنوعی و تحلیل دادهها وابسته است تا فعالیتهای مجرمانه بالقوه را پیش از وقوع پیشبینی کند. این شامل تحلیل مجموعههای دادهای بزرگ از گزارشهای جرم، سوابق دستگیری و اطلاعات اجتماعی یا جغرافیایی برای شناسایی الگوها و پیشبینی مکان وقوع جرم یا افرادی که ممکن است درگیر آن شوند، میشود.

شکست این برنامههای برجسته یک تنش حیاتی را برجسته میکند: اگرچه نهادهای مجری قانون اغلب از ابزارهای مبتنی بر هوش مصنوعی برای ایمنی عمومی دفاع میکنند، گروههای حقوق مدنی و پژوهشگران نگرانیهایی در مورد نقض حریم خصوصی، مسائل پاسخگویی و کمبود شفافیت مطرح کردهاند. با وجود این عقبنشینیهای برجسته از پلیس پیشبینیکننده، بسیاری از ادارات پلیس کوچکتر همچنان از این فناوری استفاده میکنند.

اما شواهدی وجود دارد که ابزارهای دادهمحور مبتنی بر ارزشهای دموکراتیک مانند روند عادلانه، شفافیت و پاسخگویی میتوانند جایگزین قویتری برای سیستمهای پلیس پیشبینیکننده امروزی ارائه دهند. اگر عموم مردم بتوانند بفهمند این الگوریتمها چگونه کار میکنند، به چه دادههایی وابسته هستند و چه حفاظهایی برای جلوگیری از نتایج تبعیضآمیز و سوءاستفاده از فناوری وجود دارد، چه میشود؟

ارتباط با تبریز امروز

اخبار ، گزارشات ، عکسها و فیلم های خود را برای ما ارسال دارید . برای ارسال میتوانید از طریق آدرس تلگرامی یا ایمیل استفاده کنید.