منتشر شده: ۶ مه ۲۰۲۵، ساعت ۱۴:۳۵

فیلم هیجانانگیز علمی-تخیلی «گزارش اقلیت» محصول سال ۲۰۰۲، آیندهای دیستوپیایی را به تصویر کشید که در آن یک واحد پلیس تخصصی وظیفه داشت افراد را به خاطر جرایمی که هنوز مرتکب نشدهاند دستگیر کند. این فیلم به کارگردانی استیون اسپیلبرگ و بر اساس داستانی کوتاه از فیلیپ کی. دیک، حول محور «پیشجرم» میچرخید − سیستمی که با کمک سه روانبین یا «پیشبین» آینده قتلها را پیشبینی میکرد و به پلیس اجازه میداد مداخله کند و از وقوع جرم جلوگیری نماید.

این فیلم پرسشهای اخلاقی سنگینی را مطرح میکند: چگونه میتوان کسی را به خاطر جرمی که هنوز مرتکب نشده مقصر دانست؟ و وقتی سیستم اشتباه میکند چه اتفاقی میافتد؟

اگرچه چیزی به نام «پیشبین» همهچیزدان وجود ندارد، اما اجزای کلیدی از آیندهای که «گزارش اقلیت» تصور کرده بود، حتی سریعتر از آنچه سازندگانش پیشبینی کرده بودند، به واقعیت تبدیل شدهاند. بیش از یک دهه است که ادارات پلیس در سراسر جهان از سیستمهای دادهمحور برای پیشبینی زمان و مکان وقوع جرم و افرادی که ممکن است مرتکب آن شوند استفاده میکنند.

پلیس پیشبینیکننده دیگر یک مفهوم انتزاعی یا آیندهنگرانه نیست؛ بلکه واقعیتی است. تحلیلگران بازار پیشبینی میکنند که این فناوری با رشد چشمگیری مواجه خواهد شد.

با توجه به چالشهای استفاده مؤثر و عادلانه از یادگیری ماشین پیشبینیکننده، پلیس پیشبینیکننده نگرانیهای اخلاقی قابلتوجهی را برمیانگیزد. در غیاب راهحلهای فناورانه در آینده نزدیک، رویکردی برای رسیدگی به این نگرانیها وجود دارد: استفاده دولت از این فناوری را بهعنوان موضوعی برای پاسخگویی دموکراتیک در نظر گرفتن.

تاریخچه نگرانکننده

پلیس پیشبینیکننده به هوش مصنوعی و تحلیل دادهها وابسته است تا فعالیتهای مجرمانه بالقوه را پیش از وقوع پیشبینی کند. این شامل تحلیل مجموعههای دادهای بزرگ از گزارشهای جرم، سوابق دستگیری و اطلاعات اجتماعی یا جغرافیایی برای شناسایی الگوها و پیشبینی مکان وقوع جرم یا افرادی که ممکن است درگیر آن شوند، میشود.

نیروهای مجری قانون دهههاست که از تحلیل دادهها برای ردیابی روندهای کلی استفاده میکنند. اما فناوریهای قدرتمند هوش مصنوعی امروزی، با دریافت حجم عظیمی از دادههای نظارتی و گزارشهای جرم، تحلیلهای بسیار دقیقتری ارائه میدهند.

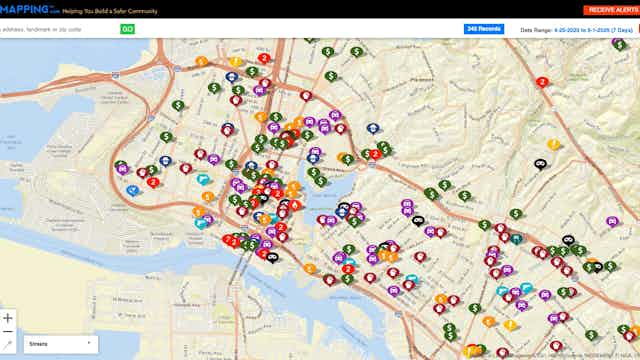

ادارات پلیس از این تکنیکها برای تعیین محل تمرکز منابع خود استفاده میکنند. پیشبینی مکانمحور بر شناسایی مکانهای پرریسک، معروف به نقاط داغ، که از نظر آماری احتمال وقوع جرم در آنها بیشتر است، تمرکز دارد. در مقابل، پیشبینی فردمحور تلاش میکند افرادی را که در معرض خطر بالای ارتکاب جرم یا قربانی شدن هستند، شناسایی کند.

این سیستمها موضوع نگرانیهای عمومی قابلتوجهی بودهاند. در برنامهای به نام «پلیس اطلاعاتمحور» در شهرستان پاسکو، فلوریدا، اداره کلانتری فهرستی از افرادی که احتمال ارتکاب جرم داشتند تهیه کرد و سپس مکرراً مأموران را به خانههای آنها فرستاد. بیش از ۱۰۰۰ نفر از ساکنان پاسکو، از جمله افراد زیر سن قانونی، تحت بازدیدهای تصادفی مأموران پلیس قرار گرفتند و برای مواردی مانند نبود شماره صندوق پستی یا علفهای بیش از حد بلند جریمه شدند.

چهار نفر از ساکنان در سال ۲۰۲۱ از این شهرستان شکایت کردند و سال گذشته به توافقی رسیدند که در آن اداره کلانتری پذیرفت که حقوق constitutional ساکنان به حریم خصوصی و رفتار برابر تحت قانون را نقض کرده است. این برنامه از آن زمان متوقف شده است.

این فقط مشکل فلوریدا نیست. در سال ۲۰۲۰، شیکاگو «فهرست سوژههای استراتژیک» خود را که در آن پلیس از تحلیل دادهها برای پیشبینی افرادی که احتمال ارتکاب جرم جدید یا قربانی تیراندازیهای آینده داشتند استفاده میکرد، کنار گذاشت. در سال ۲۰۲۱، اداره پلیس لسآنجلس استفاده از نرمافزار PredPol را که برای پیشبینی نقاط داغ جرم طراحی شده بود اما به دلیل دقت پایین و تقویت تبعیضهای نژادی و اقتصادی مورد انتقاد قرار گرفت، متوقف کرد.

نوآوریهای ضروری یا زیادهروی خطرناک؟

شکست این برنامههای برجسته یک تنش حیاتی را برجسته میکند: اگرچه نهادهای مجری قانون اغلب از ابزارهای مبتنی بر هوش مصنوعی برای ایمنی عمومی دفاع میکنند، گروههای حقوق مدنی و پژوهشگران نگرانیهایی در مورد نقض حریم خصوصی، مسائل پاسخگویی و کمبود شفافیت مطرح کردهاند. با وجود این عقبنشینیهای برجسته از پلیس پیشبینیکننده، بسیاری از ادارات پلیس کوچکتر همچنان از این فناوری استفاده میکنند.

بیشتر ادارات پلیس آمریکا سیاستهای روشنی در مورد تصمیمگیری الگوریتمی ندارند و اطلاعات کمی درباره نحوه توسعه، آموزش یا نظارت بر دقت و سوگیری مدلهای پیشبینیکنندهای که استفاده میکنند ارائه میدهند. تحلیل مؤسسه بروکینگز نشان داد که در بسیاری از شهرها، دولتهای محلی هیچ مستندات عمومی درباره نحوه عملکرد نرمافزارهای پلیس پیشبینیکننده، دادههای استفادهشده یا نحوه ارزیابی نتایج ندارند.

این عدم شفافیت در صنعت بهعنوان «جعبه سیاه» شناخته میشود. این امر مانع نظارت مستقل میشود و سؤالات جدی درباره ساختارهای اطراف تصمیمگیری مبتنی بر هوش مصنوعی ایجاد میکند. اگر شهروندی توسط یک الگوریتم بهعنوان فردی پرریسک علامتگذاری شود، چه راهحلی دارد؟ چه کسی بر عادلانه بودن این سیستمها نظارت میکند؟ چه مکانیزمهای نظارتی مستقلی در دسترس هستند؟

این سؤالات بحثهای جنجالی را در جوامع درباره اینکه آیا روش پلیس پیشبینیکننده باید اصلاح، تنظیم دقیقتر یا کاملاً کنار گذاشته شود، به راه انداخته است. برخی این ابزارها را نوآوریهای ضروری میدانند، در حالی که دیگران آنها را زیادهروی خطرناک میبینند.

راه بهتری در سن خوزه

اما شواهدی وجود دارد که ابزارهای دادهمحور مبتنی بر ارزشهای دموکراتیک مانند روند عادلانه، شفافیت و پاسخگویی میتوانند جایگزین قویتری برای سیستمهای پلیس پیشبینیکننده امروزی ارائه دهند. اگر عموم مردم بتوانند بفهمند این الگوریتمها چگونه کار میکنند، به چه دادههایی وابسته هستند و چه حفاظهایی برای جلوگیری از نتایج تبعیضآمیز و سوءاستفاده از فناوری وجود دارد، چه میشود؟

شهر سن خوزه، کالیفرنیا، فرآیندی را آغاز کرده است که هدف آن افزایش شفافیت و پاسخگویی در استفاده از سیستمهای هوش مصنوعی است. سن خوزه مجموعهای از اصول هوش مصنوعی را حفظ میکند که کمک میکند هر ابزار هوش مصنوعی مورد استفاده توسط دولت شهر مؤثر، شفاف برای عموم و عادلانه در تأثیراتش بر زندگی مردم باشد. همچنین ادارات شهر موظفاند پیش از ادغام سیستمهای هوش مصنوعی در عملیات خود، خطرات آنها را ارزیابی کنند.

اگر این اقدامات بهدرستی انجام شوند، میتوانند جعبه سیاه را باز کنند و بهطور چشمگیری توانایی شرکتهای هوش مصنوعی برای مخفی کردن کد یا دادههایشان پشت چیزهایی مانند حفاظت از اسرار تجاری را کاهش دهند. بررسی عمومی دادههای آموزشی میتواند مشکلاتی مانند سوگیری نژادی یا اقتصادی را آشکار کند، که میتوان آنها را کاهش داد، اما اگر غیرممکن نباشد، حذف کامل آنها بسیار دشوار است.

تحقیقات نشان دادهاند که وقتی شهروندان احساس میکنند نهادهای دولتی عادلانه و شفاف عمل میکنند، احتمال بیشتری دارد که در زندگی مدنی مشارکت کنند و از سیاستهای عمومی حمایت کنند. نهادهای مجری قانون اگر فناوری را بهعنوان ابزاری − و نه جایگزینی − برای عدالت در نظر بگیرند، احتمالاً نتایج بهتری خواهند داشت.